Warum kann ich nicht einfach meine Kamera auf das richten, was ich sehe, und das aufnehmen? Das ist eine scheinbar einfache Frage. Sie ist auch eine der kompliziertesten Fragen, die es zu beantworten gilt. Man muss sich nicht nur damit beschäftigen, wie eine Kamera Licht aufnimmt, sondern auch damit, wie und warum unsere Augen so funktionieren, wie sie es tun. Die Beschäftigung mit solchen Fragen kann überraschende Erkenntnisse über unsere alltägliche Wahrnehmung der Welt zutage fördern – und uns zu besseren Fotografen machen.

|

VS. |  |

EINFÜHRUNG

Unsere Augen sind in der Lage, sich in einer Szene umzusehen und sich dynamisch an das jeweilige Motiv anzupassen, während Kameras ein einzelnes Standbild aufnehmen. Diese Eigenschaft ist der Grund für viele der allgemein bekannten Vorteile, die wir gegenüber Kameras haben. So können unsere Augen z. B. den Fokus auf unterschiedlich helle Bereiche ausrichten, sich umsehen, um einen größeren Blickwinkel zu erfassen, oder abwechselnd Objekte in verschiedenen Entfernungen fokussieren.

Das Endergebnis ähnelt jedoch einer Videokamera – nicht einer Fotokamera -, die relevante Schnappschüsse zu einem geistigen Bild zusammensetzt. Ein kurzer Blick mit den Augen wäre vielleicht ein besserer Vergleich, aber letztlich ist die Einzigartigkeit unseres visuellen Systems unvermeidlich, denn:

Was wir wirklich sehen, ist die Rekonstruktion von Objekten durch unseren Verstand, die auf dem von den Augen gelieferten Input basiert – nicht auf dem tatsächlichen Licht, das unsere Augen empfangen.

Skeptisch? Die meisten sind es – zumindest anfangs. Die folgenden Beispiele zeigen Situationen, in denen der Verstand ausgetrickst werden kann, um etwas anderes zu sehen als die Augen:

Falsche Farbe

Falsche Farbe  Mach Bänder

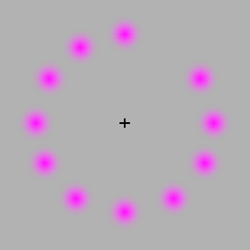

Mach Bänder Falsche Farbe: Bewegen Sie Ihre Maus auf die Ecke des Bildes und starren Sie auf das zentrale Kreuz. Der fehlende Punkt wird um den Kreis rotieren, aber nach einer Weile wird dieser Punkt grün erscheinen – obwohl kein Grün im Bild vorhanden ist.

Falschfarben: Bewegen Sie die Maus über das Bild und wieder zurück. Jedes der Bänder erscheint an den oberen und unteren Rändern etwas dunkler oder heller – obwohl alle gleichmäßig grau sind.

Das sollte uns aber nicht davon abhalten, unsere Augen und Kameras zu vergleichen! Unter vielen Bedingungen ist ein fairer Vergleich immer noch möglich, aber nur, wenn wir sowohl das, was wir sehen, als auch die Art und Weise, wie unser Geist diese Informationen verarbeitet, berücksichtigen. In den folgenden Abschnitten werden wir versuchen, diese beiden Aspekte so weit wie möglich zu trennen.

ÜBERSICHT DER UNTERSCHIEDE

Dieses Tutorial gruppiert Vergleiche in die folgenden visuellen Kategorien:

- Blickwinkel

- Auflösung &Detail

- Empfindlichkeit &Dynamischer Bereich

Die oben genannten Bereiche werden oft als die Bereiche angesehen, in denen sich unsere Augen und Kameras am meisten unterscheiden, und sind in der Regel auch die Bereiche, in denen es die meisten Meinungsverschiedenheiten gibt. Weitere Themen sind z. B. Schärfentiefe, Stereosehen, Weißabgleich und Farbskala, die jedoch nicht im Mittelpunkt dieses Lehrgangs stehen.

Blickwinkel

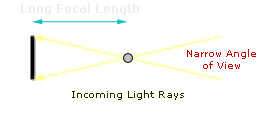

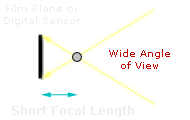

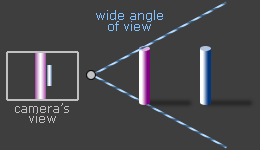

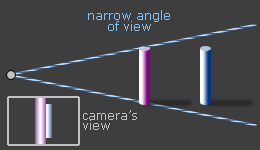

Bei Kameras wird dieser durch die Brennweite des Objektivs (und die Sensorgröße der Kamera) bestimmt. Ein Teleobjektiv hat zum Beispiel eine längere Brennweite als ein Standardobjektiv im Hochformat und umfasst daher einen engeren Blickwinkel:

Unglücklicherweise sind unsere Augen nicht so einfach. Obwohl das menschliche Auge eine Brennweite von etwa 22 mm hat, ist dies irreführend, weil (i) die Rückseite unserer Augen gekrümmt ist, (ii) die Peripherie unseres Gesichtsfeldes immer weniger Details enthält als das Zentrum und (iii) die Szene, die wir wahrnehmen, das kombinierte Ergebnis beider Augen ist.

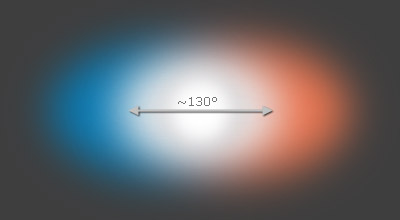

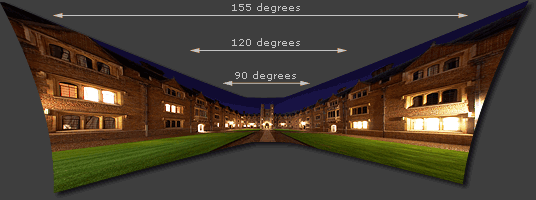

Jedes einzelne Auge hat einen Blickwinkel von 120-200°, je nachdem, wie streng man Objekte als „gesehen“ definiert. Der Bereich, in dem sich beide Augen überlappen, beträgt etwa 130° – das ist fast so breit wie ein Fischaugenobjektiv. Aus evolutionären Gründen ist unser extremes peripheres Sehen jedoch nur für die Wahrnehmung von Bewegungen und großen Objekten nützlich (z. B. ein Löwe, der von der Seite angreift). Außerdem würde ein solcher Weitwinkel stark verzerrt und unnatürlich wirken, wenn er von einer Kamera aufgenommen würde.

|

||

| Linkes Auge | Beide Augen überlappen | Rechtes Auge |

Unser zentraler Blickwinkel – etwa 40-60° – beeinflusst unsere Wahrnehmung am meisten. Subjektiv würde dies dem Winkel entsprechen, in dem Sie sich an Objekte erinnern können, ohne Ihre Augen zu bewegen. Dies entspricht übrigens in etwa einem Objektiv mit 50 mm „normaler“ Brennweite an einer Vollformatkamera (43 mm, um genau zu sein) oder einer Brennweite von 27 mm an einer Kamera mit 1,6-fachem Cropfaktor. Dies gibt zwar nicht den vollen Blickwinkel wieder, den wir sehen, aber es entspricht dem, was wir als den besten Kompromiss zwischen den verschiedenen Arten der Verzeichnung empfinden:

Weitwinkelobjektiv

Weitwinkelobjektiv(Objekte sind sehr unterschiedlich groß)

Teleobjektiv

Teleobjektiv(Objekte sind ähnlich groß)

Bei einem zu weiten Bildwinkel werden die relativen Größen der Objekte übertrieben dargestellt, Ein zu enger Blickwinkel bedeutet, dass die Objekte im Verhältnis zueinander fast gleich groß sind, und man verliert den Eindruck von Tiefe. Extrem weite Blickwinkel führen außerdem dazu, dass Objekte in der Nähe der Bildränder gestreckt erscheinen.

(bei Aufnahme mit einem Standard-/Rektilinearobjektiv)

Im Vergleich dazu rekonstruieren wir, obwohl unsere Augen ein verzerrtes Weitwinkelbild aufnehmen, dieses zu einem mentalen 3D-Bild, das scheinbar verzerrungsfrei ist.

Auflösung & DETAIL

Die meisten aktuellen Digitalkameras haben 5-20 Megapixel, was oft als weit unter unserem Sehsystem liegend bezeichnet wird. Dies beruht auf der Tatsache, dass das menschliche Auge bei einer Sehschärfe von 20/20 in der Lage ist, das Äquivalent einer 52-Megapixel-Kamera aufzulösen (unter der Annahme eines Blickwinkels von 60°).

Diese Berechnungen sind jedoch irreführend. Nur in der Mitte des Auges haben wir eine Sehschärfe von 20/20, so dass wir nie so viele Details auf einen Blick erkennen können. Außerhalb des Zentrums nimmt unsere Sehfähigkeit drastisch ab, so dass unsere Augen bei einem Abstand von nur 20° nur noch ein Zehntel der Details erkennen. In der Peripherie nehmen wir nur noch große Kontraste und minimale Farben wahr:

Qualitative Darstellung visueller Details mit einem einzigen Augenaufschlag.

Unter Berücksichtigung der obigen Ausführungen ist ein einziger Augenaufschlag also nur in der Lage, Details wahrzunehmen, die mit einer 5-15 Megapixel-Kamera vergleichbar sind (je nach Sehkraft). Unser Gehirn merkt sich Bilder jedoch nicht Pixel für Pixel, sondern speichert einprägsame Texturen, Farben und Kontraste Bild für Bild.

Um ein detailliertes mentales Bild zusammenzusetzen, fokussieren unsere Augen daher mehrere Regionen von Interesse in schneller Folge. Dadurch wird unsere Wahrnehmung effektiv gemalt:

Das Endergebnis ist ein mentales Bild, dessen Details effektiv nach Interesse priorisiert wurden. Dies hat eine wichtige, aber oft übersehene Auswirkung für Fotografen: Selbst wenn ein Foto an die technischen Grenzen der Kameradetails herankommt, zählen solche Details letztendlich nicht viel, wenn die Bilder selbst nicht einprägsam sind.

Weitere wichtige Unterschiede bei der Detailauflösung unserer Augen sind:

Asymmetrie. Jedes Auge ist eher in der Lage, Details unterhalb unserer Sichtlinie wahrzunehmen als oberhalb, und auch das periphere Sehen ist in Richtung von der Nase weg viel empfindlicher als in Richtung auf sie zu. Kameras zeichnen Bilder fast perfekt symmetrisch auf.

Betrachten bei schwachem Licht. Bei extrem schwachem Licht, z. B. bei Mond- oder Sternenlicht, beginnen unsere Augen tatsächlich, monochrom zu sehen. In solchen Situationen beginnt auch unser zentrales Sehen, weniger Details abzubilden als in der Nähe der Mitte. Viele Astrofotografen sind sich dessen bewusst und nutzen es zu ihrem Vorteil, indem sie einen schwachen Stern nur seitlich anstarren, wenn sie ihn mit ihren eigenen Augen sehen wollen.

Subtile Abstufungen. Oft wird den feinsten auflösbaren Details zu viel Aufmerksamkeit geschenkt, aber auch subtile Tonabstufungen sind wichtig – und zufällig der Punkt, an dem sich unsere Augen und Kameras am meisten unterscheiden. Mit einer Kamera ist ein vergrößertes Detail immer leichter aufzulösen – aber kontraintuitiv kann ein vergrößertes Detail für unsere Augen sogar weniger sichtbar werden. Im folgenden Beispiel enthalten beide Bilder eine Textur mit demselben Kontrast, die jedoch im rechten Bild nicht sichtbar ist, weil die Textur vergrößert wurde.

Feine Textur

Feine Textur(kaum sichtbar)

→

Vergrößert 16X

Grobtextur

Grobtextur(nicht mehr sichtbar)

Empfindlichkeit & DYNAMISCHER BEREICH

Der dynamische Bereich* ist ein Bereich, in dem dem Auge oft ein großer Vorteil zugeschrieben wird. Wenn wir Situationen betrachten, in denen sich unsere Pupille für verschiedene Helligkeitsbereiche öffnet und schließt, dann übertreffen unsere Augen die Möglichkeiten eines einzelnen Kamerabildes bei weitem (und können einen Bereich von mehr als 24 Blendenstufen haben). Allerdings passt sich unser Auge in solchen Situationen dynamisch an wie eine Videokamera, so dass dies wohl kein fairer Vergleich ist.

|

|

|

| Auge fokussiert auf Hintergrund | Auge fokussiert auf Vordergrund | Unser mentales Bild |

Wenn wir stattdessen den momentanen Dynamikbereich unseres Auges betrachten (bei dem die Pupillenöffnung unverändert bleibt), dann schneiden Kameras viel besser ab. Das wäre so, als würden wir einen bestimmten Bereich in einer Szene betrachten, unsere Augen sich darauf einstellen lassen und nirgendwo anders hinschauen. In diesem Fall schätzen die meisten, dass unsere Augen einen Dynamikbereich von 10-14 Blendenstufen wahrnehmen können, was die meisten Kompaktkameras (5-7 Blendenstufen) deutlich übertrifft, aber überraschenderweise dem Dynamikbereich digitaler Spiegelreflexkameras (8-11 Blendenstufen) ähnelt.

Andererseits hängt der Dynamikbereich unseres Auges auch von der Helligkeit und dem Motivkontrast ab, so dass das oben Gesagte nur für typische Tageslichtbedingungen gilt. Bei der Betrachtung von Sternen bei schwachem Licht können unsere Augen beispielsweise einen noch höheren momentanen Dynamikbereich erreichen.

*Quantifizierung des Dynamikbereichs. Die gebräuchlichste Einheit für die Messung des Dynamikumfangs in der Fotografie ist die Blende, daher bleiben wir hier bei dieser. Sie beschreibt das Verhältnis zwischen den hellsten und dunkelsten aufnehmbaren Bereichen einer Szene in Zweierpotenzen. Eine Szene mit einem Dynamikbereich von 3 Blendenstufen hat also ein Weiß, das 8x so hell ist wie sein Schwarz (da 23 = 2x2x2 = 8).

Fotos links (Streichhölzer) und rechts (Nachthimmel) von lazlo bzw. dcysurfer.

Empfindlichkeit. Dies ist eine weitere wichtige visuelle Eigenschaft und beschreibt die Fähigkeit, sehr schwache oder sich schnell bewegende Motive aufzulösen. Bei hellem Licht sind moderne Kameras besser in der Lage, sich schnell bewegende Motive aufzulösen, wie zum Beispiel bei ungewöhnlich aussehenden Hochgeschwindigkeitsaufnahmen. Dies wird oft durch Kamera-ISO-Empfindlichkeiten von mehr als 3200 ermöglicht; man geht sogar davon aus, dass der entsprechende Tageslicht-ISO-Wert für das menschliche Auge bei nur 1 liegt.

Unter schlechten Lichtverhältnissen werden unsere Augen jedoch viel empfindlicher (vorausgesetzt, wir lassen sie sich mehr als 30 Minuten lang anpassen). Astrofotografen schätzen diese Empfindlichkeit oft auf etwa ISO 500-1000; das ist immer noch nicht so hoch wie bei Digitalkameras, aber nahe dran. Andererseits haben Kameras den Vorteil, dass sie längere Belichtungen machen können, um auch schwächere Objekte hervorzuheben, während unsere Augen keine zusätzlichen Details sehen, wenn sie länger als 10-15 Sekunden auf etwas starren.

ZUSAMMENFASSUNGEN & WEITERLESEN

Man könnte behaupten, dass es unerheblich ist, ob eine Kamera in der Lage ist, das menschliche Auge zu übertreffen, weil Kameras einen anderen Standard erfordern: Sie müssen realistisch aussehende Abzüge machen. Ein gedrucktes Foto weiß nicht, auf welche Bereiche sich das Auge konzentrieren wird, so dass jeder Teil einer Szene ein Maximum an Details enthalten muss – nur für den Fall, dass wir uns darauf konzentrieren werden. Dies gilt vor allem für große oder nahsichtige Abzüge. Man könnte jedoch auch behaupten, dass es immer noch nützlich ist, die Fähigkeiten einer Kamera in einen Kontext zu setzen.

Insgesamt beruhen die meisten Vorteile unseres visuellen Systems auf der Tatsache, dass unser Verstand in der Lage ist, die Informationen unserer Augen intelligent zu interpretieren, während wir bei einer Kamera nur das Rohbild haben. Dennoch schneiden die aktuellen Digitalkameras erstaunlich gut ab und übertreffen unsere Augen in einigen visuellen Fähigkeiten. Der wahre Gewinner ist der Fotograf, der in der Lage ist, mehrere Kamerabilder intelligent zusammenzusetzen – und damit sogar unser eigenes geistiges Bild zu übertreffen.

Weitere Informationen zu diesem Thema finden Sie unter:

- Hoher Dynamikbereich. Wie man den Dynamikbereich von Digitalkameras durch Mehrfachbelichtungen erweitern kann. Die Ergebnisse können sogar das menschliche Auge übertreffen.

- Graduated Neutral Density (GND)-Filter. Eine Technik zur Verbesserung des Aussehens von Szenen mit hohem Kontrast, ähnlich wie wir uns ein Bild im Kopf machen.

- Fotostitching – Digitale Panoramen. Eine allgemeine Diskussion über die Verwendung mehrerer Fotos zur Verbesserung des Blickwinkels.